摘要: 半导体供应商可以积极寻求为人工智能训练开发新器件并由此获得新商机。

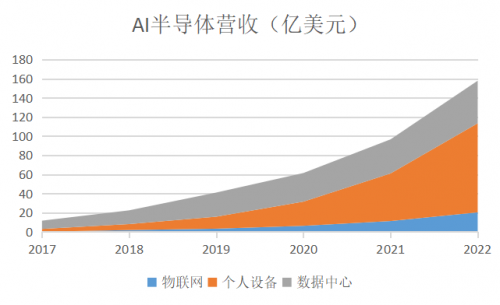

受物联网、个人设备、数据中心的强劲带动,未来五年,人工智能为半导体带来的收益将增长13倍以上,年复合增长率超过50%,成为集成电路厂商不可错过的蓝海盛宴。

尤其在以下这几个领域,半导体供应商可以积极寻求为人工智能训练开发新器件并由此获得新商机。

工作负载加速器。目前,基于GPU的系统正在许多训练系统中使用。然而,随着开发人员获得神经网络算法的经验,对替代计算架构的需求可能随着针对特定神经网络模型的器件需求而演变。许多半导体供应商正在开发专用的AI加速器,例如,Intel Crest系列产品和Graphcore的智能处理单元(IPU)。谷歌还开发了自己的基于专用集成电路(ASIC)的解决方案,一款已进入第二代的张量处理单元(TPU)。现场可编程门阵列(FPGA)也可用于满足神经网络训练的一些需求,但是,许多当前的算法都使用32位浮点运算,这可能会限制FPGA可以支持的并行度。

内存。在数据带宽和内存密度方面,提供高吞吐量并行处理会对所使用的内存子系统带来挑战。今天,许多AI设备使用高带宽存储器(HBM)技术,该技术使用安装在与主处理芯片相同的基板上的堆叠DRAM管芯。目前的HBM2规范可实现每个芯片堆栈高达256 GB/秒的传输速率和每个堆栈4 GB;对于具有四个HBM2堆栈的处理器件,这提供了1 TB/秒的理论最大数据带宽和16 GB的封装内存。除了这种快速本地连接的存储器之外,AI系统通常还需要在主系统存储器中容纳大量数据。

存储器内部处理。不同于处理内存附近的数据,“在存储器内部处理”,将计算嵌入到内存阵列中,使处理器和内存耦合更紧密。存储器内部处理可以提供额外的优势,包括更精细的并行性和更高效的性能和能效。目前,计算机行业直接插入式替换这种存储器内部处理并不普及。然而,新兴的存储器技术,包括自旋转移扭矩RAM(SST RAM)、电阻RAM(RRAM)、相变存储器(也称为PCRAM)和Intel/Micron的3D XPoint存储器,为半导体供应商提供了未来AI应用实现存储器内部处理的机会。

互连。器件和系统之间的互连性能将极大限制AI培训系统的扩展。今天,许多加速器器件通过Peripheral Component Interconnect Express(PCIe)3.0连接到主系统的微处理单元(MPU)和存储器阵列。许多行业联盟,如CCIX联盟、OpenCAPI联盟和Gen-Z联盟,正致力于定义可用于互连异构计算系统的缓存一致性互连标准。还有许多专有的系统内互连,例如,英特尔的UPI、AMD的Infinity Fabric和Nvidia的NVLink。所有这些互连为半导体供应商提供了使其AI加速器器件能够与主系统处理器及其存储器子系统连接的机制,虽然可能有必要协商访问互联的规范。

封装选项。许多专为AI训练而设计的器件将采用大型高性能芯片,甚至可能需要多个芯片才能提供最高水平的性能。这种情况为封装供应商提供了为支持这些产品而开发和提供新技术的机会。当前有一些异构封装选项的例子,包括英特尔开发的2D嵌入式多层互连桥接(EMIB)封装技术,台积电在多芯片和3D IC上采用的衬底晶圆芯片(CoWoS)技术。由许多封装和测试公司及代工厂提供的扇出晶圆级封装(FOWLP)或板级封装,也将允许以更薄的外形和更好的散热来实现芯片的低成本3D集成。

社群二维码

关注“华强商城“微信公众号

Copyright 2010-2023 hqbuy.com,Inc.All right reserved. 服务热线:400-830-6691 粤ICP备05106676号 经营许可证:粤B2-20210308